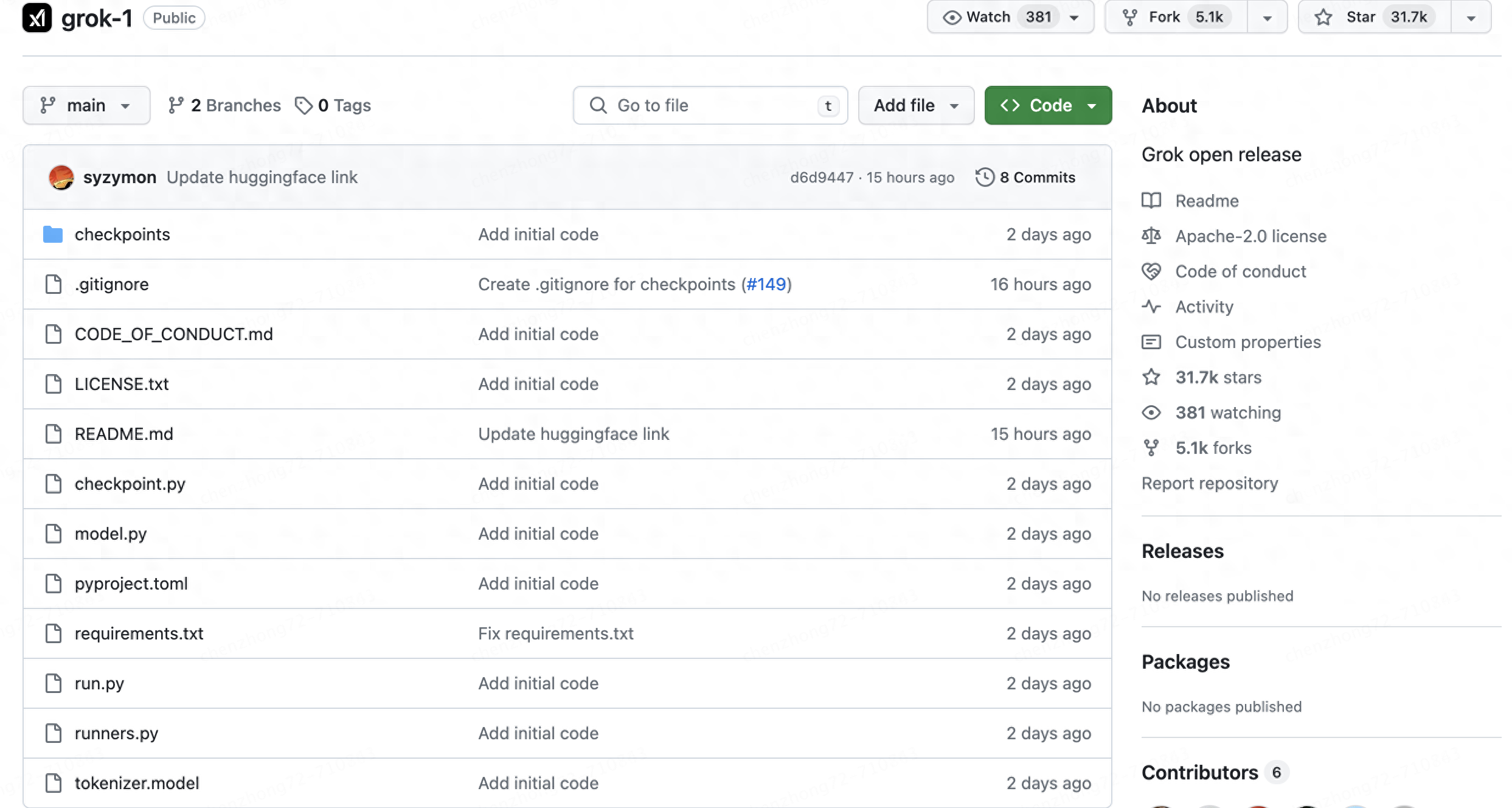

GitHub链接:

居然短短一天就有29k的star!

Grok-1的模型参数:

•Parameters:314B

•Architecture:Mixtureof8Experts(MoE)

•ExpertsUtilization:2expertsusedpertoken

•Layers:64

•AttentionHeads:48forqueries,8forkeys/values

•EmbeddingSize:6,144

•Tokenization:SentencePiecetokenizerwith131,072tokens

•AdditionalFeatures:Rotaryembeddings(RoPE)

•Supportsactivationshardingand8-bitquantization

•MaximumSequenceLength(context):8,192tokens

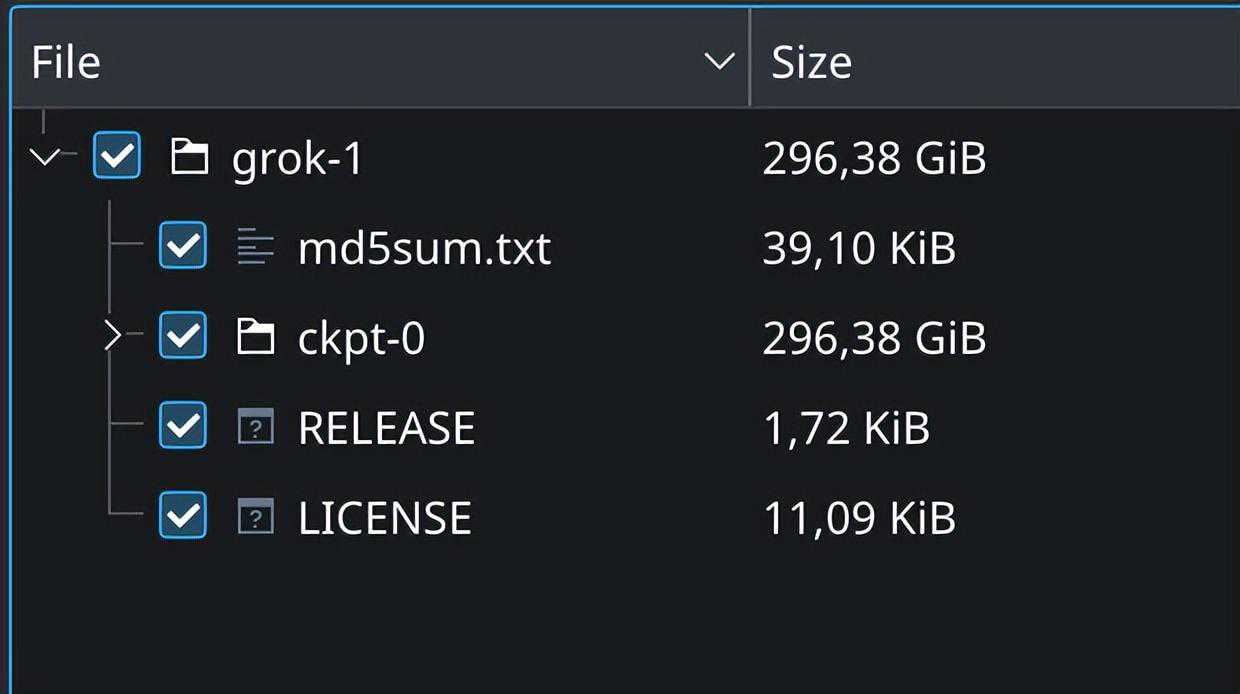

第一步:下载模型权重用户需要确保先下载checkpoint,并将ckpt-0目录放置在checkpoint中。

模型权重约为296.38GB,如下图,要注意自己磁盘的容量

有下面两种下载方法

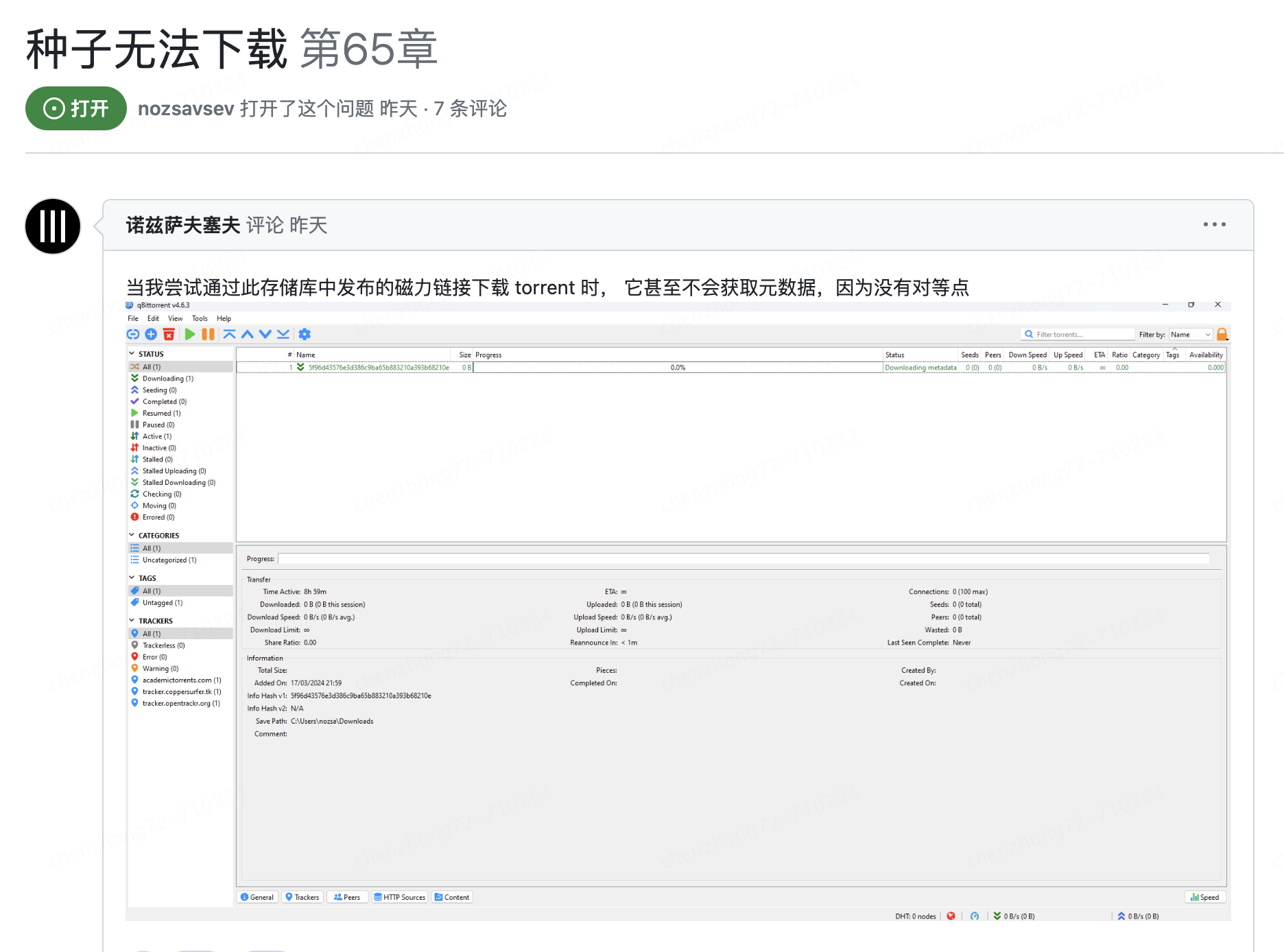

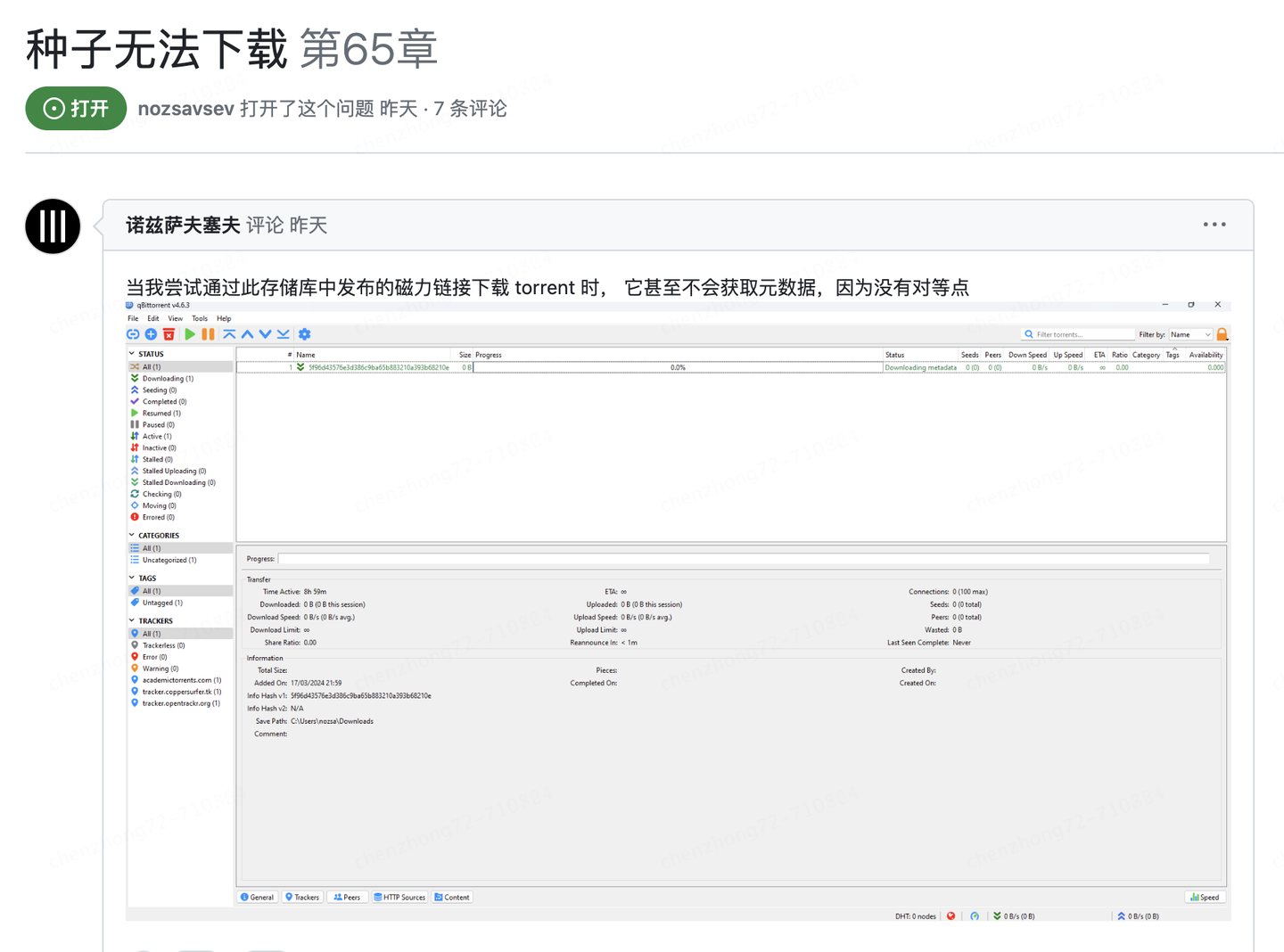

1.可以使用torrent客户端和此磁力链接下载权重

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210etr=https%3A%2F%2%2=udp%3A%2F%2%3A6969tr=udp%3A%2F%2%3A1337%2Fannounce

2.直接使用HuggingFace

执行下面的代码

gitclone;cdgrok-1pipinstallhuggingface_hub[hf_transfer]huggingface-clidownloadxai-org/grok-1--repo-typemodel--includeckpt-0/*--local-dircheckpoints--local-dir-use-symlinksFalse第二步:运行大模型

安装依赖环境,执行代码

的文件内容:

dm_haiku==0.0.12jax[cuda12_pip]==0.4.25-f

然后执行代码

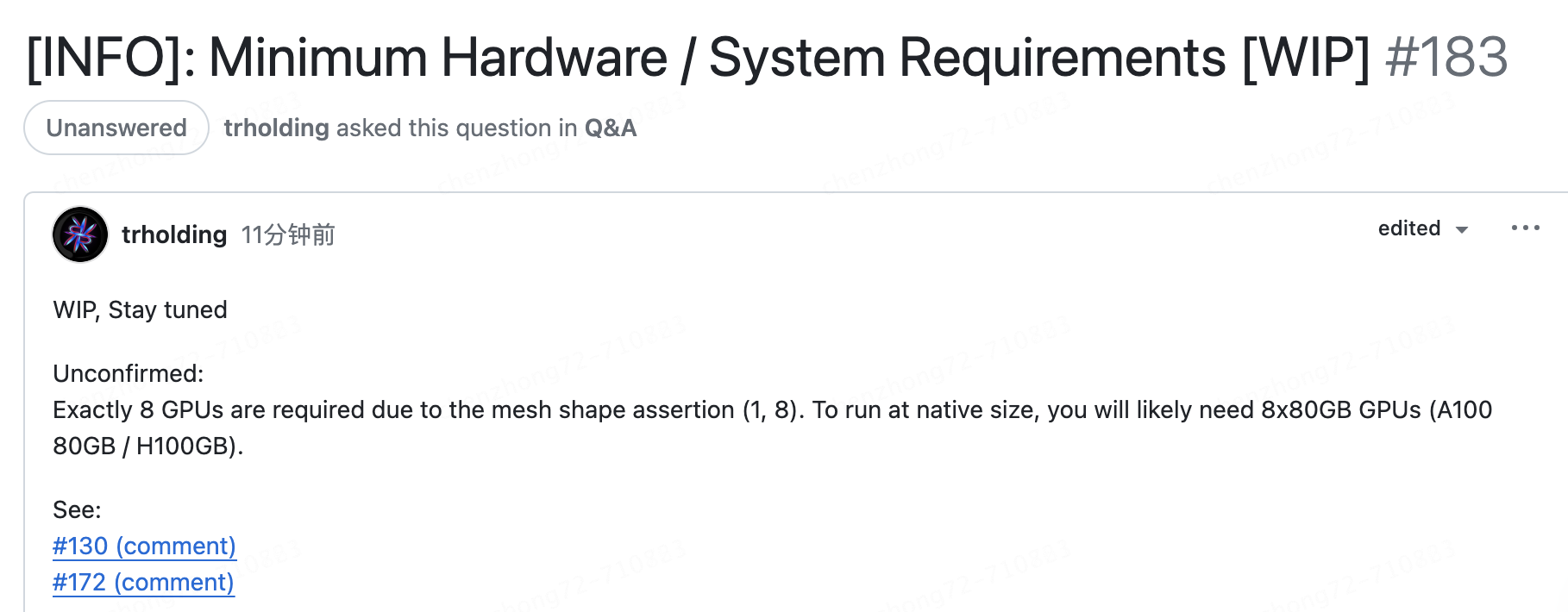

注意:硬件要求多大呢?由于模型规模较大(314B参数),需要有足够GPU、内存的机器才能使用示例代码测试模型。

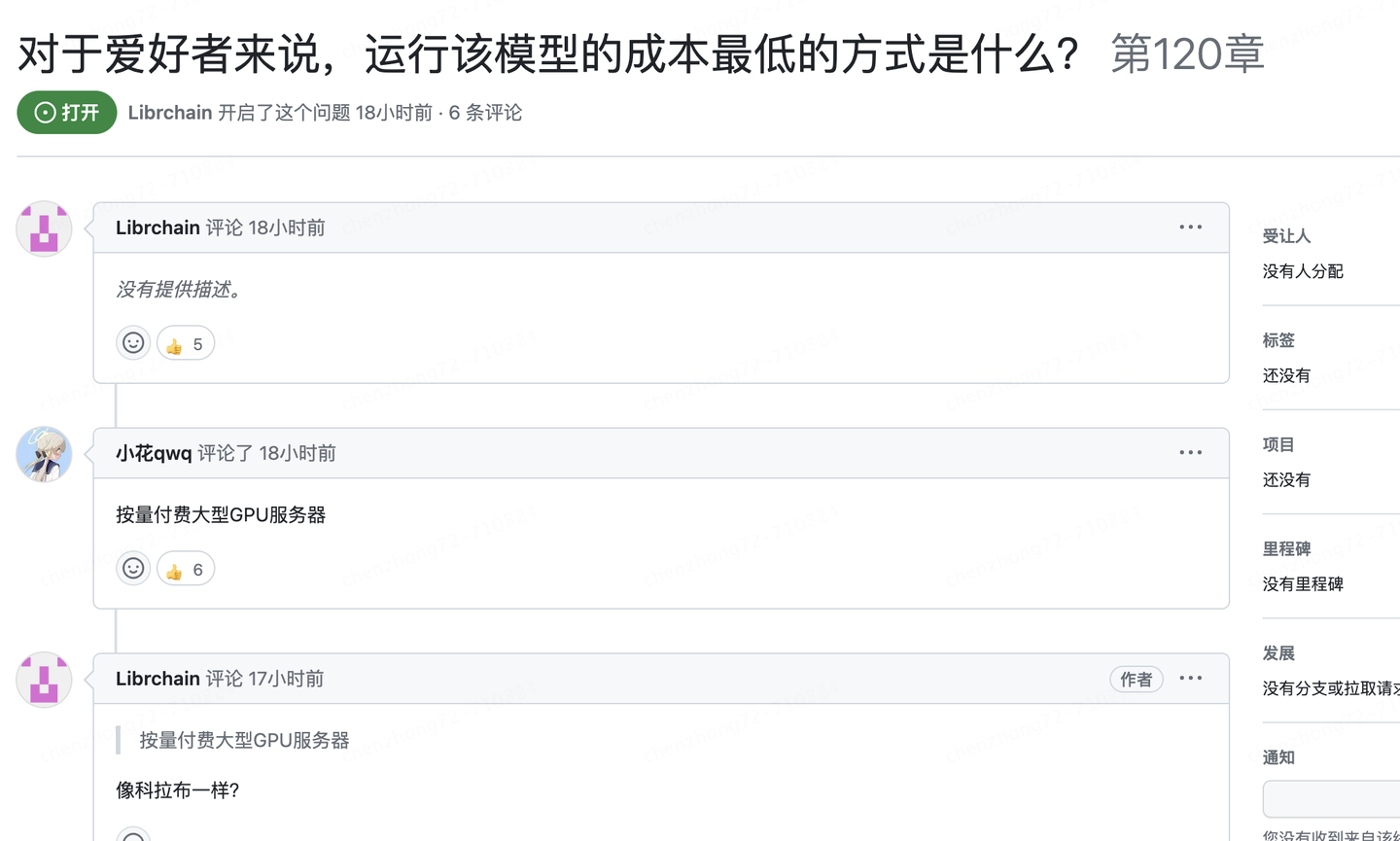

那具体需要多大呢?

这个也是提的比较多的问题,有人给出了回复,但暂时未确认

由于由于themeshshapeassertion(1,8),因此需要8个GPU。要以本机大小运行,您可能需要8x80GBGPU(A10080GB/H100GB)。

详见issue:

容易出现的问题大家遇到比较多的是下载问题,比如种子无法下载

还有硬件资源的问题,毕竟需要的gpu和内存太高了,对于个人来说成本太高了,个人没法玩了啊

-

《鬼泣-巅峰之战》游戏评测

2026-01-14 -

可以上发条的莫扎特音乐球

2025-03-18 -

我的第一个游戏做了个农场种菜游戏,圆自己农场主的愿望

2025-05-27 -

经典MMO《传奇4》每月赚一亿?玩家惊呆:还说端游凉凉吗

2025-05-07

版权所有 © Copyright © 2002-2030 龙辉游戏资讯网站地图